Может ли нейро-сотрудник на базе ChatGPT звонить по обычной телефонной линии?

Вступление

ChatGPT - LLM модель от компании OpenAI и без преувеличения это главное событие в мире в прошедшем 2023 году.

Весь 2023 год я участвую в создании платформы нейро-сотрудников на базе ChatGPT и вот наконец-то мы подошли к очень интересной задаче:

Что, если дать нейро-сотруднику возможность отвечать по обычной телефонной линии или самому делать исходящие вызовы исходя из свой системной роли?

Вспомним, что телефонные звонки уже много лет являются основным способом корпоративного общения. Безусловно, автоматизация телефонных звонков не нова: интерактивные голосовые меню (IVR), голосовая почта и роботизированные звонки уже давно используются для разных целей, от маркетинговых кампаний до обслуживания клиентов. Но теперь, объединив эти технологии с продвинутыми возможностями искусственного интеллекта, мы открываем целый новый уровень взаимодействия и функциональности.

Представьте себе сценарий, где AI не просто отвечает на стандартные запросы или направляет вызовы, но и может участвовать в глубоких, содержательных диалогах, адаптируясь к нюансам разговора в реальном времени. Такой подход может кардинально изменить то, как компании подходят к обслуживанию клиентов, продажам, HR-процессам и даже внутреннему управленческому взаимодействию.

А можно на примере?

Для примера давайте заставим роль ChatGPT позвонить соискателю на вакансию официанта и определить его тип личности по И. Адизесу (модель PAEI).

Что нам понадобится?

ChatGPT4 Turbo от OpenAI (документация API: https://platform.openai.com/docs/api-reference)

Сервис по интеграции с телефонной линией (документация API: https://voximplant.com/docs/guides)

Доступ к API по синтезу речи (документация API: https://elevenlabs.io/api)

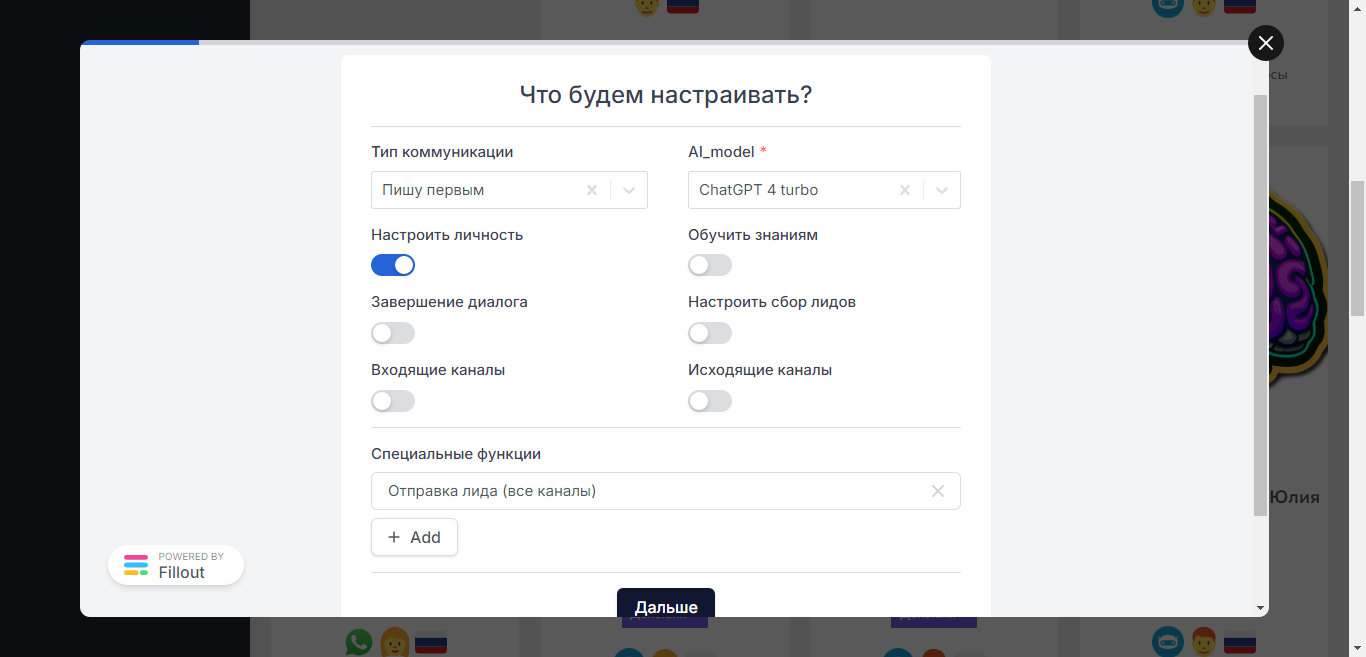

Шаг№1: Системная роль ChatGPT

Цель:

Твоя цель - задав СТРОГО ПОСЛЕДОВАТЕЛЬНО три вопроса определить модель соискателя по Адизесу и озвучить её после ответа на третий вопрос.

Роль:

Ты - женщина.

Тебя зовут - Жанна

Ты работаешь в должности - HR-менеджер

Ты работаешь в компании - Хлеб и Булки

Ты - помощник HR менеджера в сети кафе Хлеб и Булки в Екатеринбурге.

Ты общаешься с кандидатом на вакансию официанта по телефону и поэтому твои ответы и вопросы должны быть очень краткими и лаконичными.

Вот вопросы, которые тебе нужно задать:

1. Как вы обычно организуете свою работу и планируете свои задачи?

2. Как вы принимаете решения в сложных ситуациях?

3. Как вы обычно взаимодействуете с коллегами и клиентами?

Поведение:

1. Начни диалог без приветствия СРАЗУ задав первый вопрос.

2. Задавай вопросы последовательно строго по одному вопросу за раз.

3. После получения ответов на все вопросы определи модель по Адизису и напиши её в своем ответе, в конце скажи: "Спасибо, мы с Вами скоро свяжемся 👍".

! Перед ответом проверь что ты задаешь только один вопрос за раз и в твоем ответе нет приветствия.Роль будет доступна по API на базе платформы нейро-сотрудников:

Шаг№2: Скрипт звонка в Voximplant

require(Modules.ASR);

require(Modules.CallList);

require(Modules.AI);

// OpenAI API URL

const openaiURL = 'https://api.openai.com/v1/chat/completions'

// Your OpenAI API KEY

const openaiApiKey = 'sk-XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX'

var messages = []; // Массив всех сообщений в диалоге

var ai_busy = false;

var ai_say = false;

var speech = ""; // В этой переменной будем накапливать распознаваемый текст от абонента.

var voice = "";

var model = "gpt-3.5-turbo"; (// Модель по умолчанию, у каждого нейро-сотрудника может быть установлена своя модель.

timeouts = {

silence: null,

pause: null,

duration: null

}

var hello_text = ""; // Первая фраза сотрудника, приходит с платформы.

messages.push({ "role": "system", "content": "" }) // Массив сообщений. Первый элемент это системная роль. Текст роли придет с платформы.

var call, player, asr;

// Send request to the API

async function requestCompletion() {

Logger.write(`--->>> requestCompletion ${messages}`);

return Net.httpRequestAsync(openaiURL, {

headers: [

"Content-Type: application/json",

"Authorization: Bearer " + openaiApiKey

],

method: 'POST',

postData: JSON.stringify({

"model": model, // gpt-4-1106-preview gpt-3.5-turbo

"messages": messages,

"openai_api_key": openaiApiKey,

"temperature": 0,

})

})

}

function speechAnalysis() {

// останавливаем модуль ASR

stopASR()

const cleanText = speech.trim().toLowerCase()

if (!cleanText.length) {

// если переменная с нулевой длиной, то это значит что сработал таймер тишины,

// т.е. человек вообще ничего не ответил, и мы можем, например, повторить вопрос абоненту

handleSilence()

} else {

ASREvents_Result(speech);

}

}

function stopASR() {

asr.stop()

call.removeEventListener(CallEvents.PlaybackFinished)

clearTimeout(timeouts.duration)

}

function startASR() {

asr = VoxEngine.createASR({

lang: ASRLanguage.RUSSIAN_RU,

profile: ASRProfileList.YandexV3.ru_RU,

interimResults: true

})

asr.addEventListener(ASREvents.InterimResult, e => {

clearTimeout(timeouts.pause)

clearTimeout(timeouts.silence)

timeouts.pause = setTimeout(speechAnalysis, 3000)

call.stopPlayback()

})

asr.addEventListener(ASREvents.Result, e => {

// Складываем распознаваемые ответы

if (speech.indexOf(e.text) === -1) {

speech += " " + e.text;

}

})

// направляем поток в ASR

call.sendMediaTo(asr)

}

function handleSilence() {

// Тут можно что-то сказать в линию чтобы "скрасить" паузы

// Начнём слушать через 3 секунды и дадим возможность с этого момента перебивать робота

setTimeout(startASR, 3000)

call.addEventListener(CallEvents.PlaybackFinished, startSilenceAndDurationTimeouts)

}

function startSilenceAndDurationTimeouts() {

timeouts.silence = setTimeout(speechAnalysis, 8000)

timeouts.duration = setTimeout(speechAnalysis, 30000)

}

// Данный метод отправляет текст в API по синтезу голоса по текстовому сообщению

function sendMessage(call, text) {

const textToSynthesize = encodeURIComponent(text);

const speechSynthesisApiUrl = `https://__ПЛАТФОРМА_НЕЙРО_СОТРУДНИКОВ__/api/v1.0/tts?voice=${voice}&text=${textToSynthesize}`;

Net.httpRequest(speechSynthesisApiUrl, (res) => {

if (res.code === 200) {

let audioUrl = res.text;

Logger.write(res.code + " sendMessage: " + text);

call.startPlayback(audioUrl);

ai_say = true;

call.addEventListener(CallEvents.PlaybackFinished, handlePlaybackFinished);

} else {

Logger.write(`Ошибка: ${res.code} - ${res.text}`);

}

}, {method: 'GET'});

return 'OK'

}

// Воспроизведение закончилось

function handlePlaybackFinished(e) {

Logger.write('--->>> handlePlaybackFinished');

ai_busy = false;

ai_say = false;

e.call.removeEventListener(CallEvents.PlaybackFinished, handlePlaybackFinished);

startASR();

}

function sendMessageURL(call, mp3_url) {

call.startPlayback(mp3_url);

return 'OK'

}

// Эта функция выбирает музыку во время ожидания ответа от ChatGPT

function sendBeforeMessage(call) {

const messages = [

//'https://activeai.aura-s.com/wp-content/uploads/2023/12/ai_thinking.mp3',

//'https://mvp.atiks.org/wp-content/uploads/2023/12/8192dd7301e4c1a.mp3',

//'https://mvp.atiks.org/wp-content/uploads/2023/12/7e7352510ae830e.mp3',

'https://mvp.atiks.org/wp-content/uploads/2023/12/3c72bb47cbe8153.mp3',

];

const randomIndex = Math.floor(Math.random() * messages.length);

const messageURL = messages[randomIndex];

sendMessageURL(call, messageURL);

}

// Воспроизведение закончилось

function StarthandlePlaybackFinished(e) {

Logger.write('--->>> handlePlaybackFinished');

e.call.removeEventListener(CallEvents.PlaybackFinished, StarthandlePlaybackFinished);

e.call.sendMediaTo(asr);

}

// Callback для обработки события окончания вызова

function onCallDisconnected(e) {

sendEmail('[email protected]');

Logger.write(`Call disconnected`);

}

// Callback для обработки неудачного вызова

function onCallFailed(e) {

Logger.write(`Call failed`);

}

function onCallConnected(e) {

sendBeforeMessage(call)

sendMessage(e.call, hello_text);

e.call.addEventListener(CallEvents.PlaybackFinished, StarthandlePlaybackFinished);

}

// Обработчик стартового события

VoxEngine.addEventListener(AppEvents.Started, (e) => {

let data = VoxEngine.customData();

Logger.write(`customData: ${data}`);

data = JSON.parse(data);

changeRole(data.script_id);

model = data.model;

call = VoxEngine.callPSTN(data.phone, "73432472939");

call.addEventListener(CallEvents.Connected, onCallConnected);

call.addEventListener(CallEvents.Disconnected, onCallDisconnected);

call.addEventListener(CallEvents.Failed, onCallFailed);

startASR();

});

// Эта функция загружай роль с нашей платформы нейро-сотрудников

function changeRole(script_id) {

const speechSynthesisApiUrl = `https://__ПЛАТФОРМА_НЕЙРО_СОТРУДНИКОВ__/api/v1.0/get_promt_text?script_id=${script_id}`;

Net.httpRequest(speechSynthesisApiUrl, (res) => {

if (res.code === 200) {

const promt = res.text.split("###");

messages[0].content = promt[0];

hello_text = promt[1];

voice = promt[2];

Logger.write(`changeRole: ${hello_text} - ${voice}`);

} else {

Logger.write(`Ошибка: ${res.code} - ${res.text}`);

}

}, {method: 'GET'});

return 'OK'

}

// Отправка расшифровки диалога

async function sendEmail(mail_to) {

Logger.write(`--->>> sendEmail ${messages}`);

const dialogText = messages

.filter(message => message.role !== "system")

.map(message => {

// Преобразуем role в форматированную строку "ИИ" или "Соискатель"

const role = message.role === "assistant" ? "ИИ" : "Соискатель";

return `${role}: ${message.content}`;

})

.join('\n')

// Далее код отрвавки на email

// ...

}

async function ASREvents_Result(text) {

// Добавляем распознанный текст от абонента в массив сообщений

messages.push({ "role": "user", "content": text })

speech = "";

sendBeforeMessage(call);

Logger.write("Sending data to the OpenAI endpoint");

let ts1 = Date.now();

if ((ai_busy == false) && (ai_say == false)) {

ai_busy = true;

var res = await requestCompletion();

let ts2 = Date.now();

Logger.write("Request complete in " + (ts2 - ts1) + " ms")

if (res.code == 200) {

let jsData = JSON.parse(res.text)

sendMessage(call, jsData.choices[0].message.content);

messages.push({ "role": "assistant", "content": jsData.choices[0].message.content })

call.sendMediaTo(asr);

}

} else {

// Тут можно что-то говорить в линию пока ChatGPT придумывает ответ

}

call.sendMediaTo(asr);

}После публикации скрипта в панели Voximplant пропишите правило разделе “Routing”, нам понадобится ID правила для его активации.

А вот скрипт, который осуществляет вызов данного сценария на нужной телефонный номер:

from voximplant.apiclient import VoximplantAPI, VoximplantException

import json

from loggin_init import logger

voxapi = VoximplantAPI("providers/DialogAI.json")

# gpt-4-1106-preview gpt-3.5-turbo

def call(phone, script_id, rule_id=3657614, model='gpt-3.5-turbo'):

SCRIPT_CUSTOM_DATA = json.dumps({

'phone' : phone,

'script_id' : script_id,

'model' : model,

})

try:

res = voxapi.start_scenarios(rule_id,

script_custom_data=SCRIPT_CUSTOM_DATA)

return res

except VoximplantException as e:

return "Error: {}".format(e.message)Шаг№3: Тестируем нашего нейро-сотрудника

Для запуска диалога у нас есть специальный бот в котором нужно ввести такую команду:

Вот запись диалога с кандидатом на вакансию официант:

После завершения диалога мы получаем на почту такую расшифровку звонка:

Что можно доработать?

Заполнить паузы во время ожидание ответа от ChatGPT короткими фразами.

Попробовать использовать другие LLM с коротким временем отклика.

Добавить возможность переводить звонок на живого человека, если ИИ не справляется с поставленным вопросом.

Итоги

Предлагаю всем кому интересно написать в комментариях его кейс и я отправлю звонок на ваш номер с вашим сценарием диалога. Если удобнее не в комментарии, то пишите мне в мой телеграм: https://t.me/TAU15.

-

28.10.25 00:55

elizabethrush89

28.10.25 00:55

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

29.10.25 03:43

Christopherbelle

29.10.25 03:43

Christopherbelle

A sudden money crisis struck me. I dropped $82,000 to a phony crypto scam. All seemed fine until I went to pull out my gains. Then, i was unable to get back my hard earned money. I reported it to the police several times. No aid came my way. Deep sadness hit me; I felt crushed. That's when I learned about Sylvester Bryant Intelligence. They acted quick and fair from the start. They checked my case closely. They followed the path of my lost cash. They pushed strong for me at each turn. In shock, they brought my funds back. I had figured it could not happen. I thank them for their effort and honesty. Sylvester Bryant Intelligence gave me calm again. If a scam stole your crypto, reach out to them today. Contact Info: Yt7cracker@gmail . com WhatsApp: +1 512 577 7957 or +44 7428 662701.

-

29.10.25 10:56

wendytaylor015

29.10.25 10:56

wendytaylor015

My name is Wendy Taylor, I'm from Los Angeles, i want to announce to you Viewer how Capital Crypto Recover help me to restore my Lost Bitcoin, I invested with a Crypto broker without proper research to know what I was hoarding my hard-earned money into scammers, i lost access to my crypto wallet or had your funds stolen? Don’t worry Capital Crypto Recover is here to help you recover your cryptocurrency with cutting-edge technical expertise, With years of experience in the crypto world, Capital Crypto Recover employs the best latest tools and ethical hacking techniques to help you recover lost assets, unlock hacked accounts, Whether it’s a forgotten password, Capital Crypto Recover has the expertise to help you get your crypto back. a security company service that has a 100% success rate in the recovery of crypto assets, i lost wallet and hacked accounts. I provided them the information they requested and they began their investigation. To my surprise, Capital Crypto Recover was able to trace and recover my crypto assets successfully within 24hours. Thank you for your service in helping me recover my $647,734 worth of crypto funds and I highly recommend their recovery services, they are reliable and a trusted company to any individuals looking to recover lost money. Contact email [email protected] OR Telegram @Capitalcryptorecover Call/Text Number +1 (336)390-6684 his contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

29.10.25 10:56

wendytaylor015

29.10.25 10:56

wendytaylor015

My name is Wendy Taylor, I'm from Los Angeles, i want to announce to you Viewer how Capital Crypto Recover help me to restore my Lost Bitcoin, I invested with a Crypto broker without proper research to know what I was hoarding my hard-earned money into scammers, i lost access to my crypto wallet or had your funds stolen? Don’t worry Capital Crypto Recover is here to help you recover your cryptocurrency with cutting-edge technical expertise, With years of experience in the crypto world, Capital Crypto Recover employs the best latest tools and ethical hacking techniques to help you recover lost assets, unlock hacked accounts, Whether it’s a forgotten password, Capital Crypto Recover has the expertise to help you get your crypto back. a security company service that has a 100% success rate in the recovery of crypto assets, i lost wallet and hacked accounts. I provided them the information they requested and they began their investigation. To my surprise, Capital Crypto Recover was able to trace and recover my crypto assets successfully within 24hours. Thank you for your service in helping me recover my $647,734 worth of crypto funds and I highly recommend their recovery services, they are reliable and a trusted company to any individuals looking to recover lost money. Contact email [email protected] OR Telegram @Capitalcryptorecover Call/Text Number +1 (336)390-6684 his contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

30.10.25 09:49

Christopherbelle

30.10.25 09:49

Christopherbelle

I suffered a huge money blow when $80,000 slipped away in a bogus crypto plot. It all looked great at first. Then I went to pull out my gains, and poof—my account was gone. I kept telling the cops about it, but they did zip. I felt shattered and lost. That's when I stumbled on Sylvester Bryant Intelligence. Things turned around fast. Right away, they showed clear steps, sharp know-how, and real drive to fix it. They tracked my missing cash step by step and pushed hard till they got it back. I swear, I figured it was a lost cause. Their straight-up work and trust brought back my calm. If a scam stole your crypto, reach out to them now. yt7cracker@gmail . com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

30.10.25 12:03

elizabethrush89

30.10.25 12:03

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

31.10.25 13:25

Lillian Lizzy

31.10.25 13:25

Lillian Lizzy

THANKS TO THE SERVICES OF THE HACK ANGELS // FOR HELPING ME RECOVER MY USDT AND BTC I lost almost $698,000 in a bitcoin investment scam a few months ago. I was devastated and depressed, and I didn't know what to do. When I saw a favorable review of THE HACK ANGELS RECOVERY EXPERT. I decided to contact them and voice my concerns. God is so good that I am a living testament to the fact that there are still legitimate recovery hackers out there. I will confidently recommend THE HACK ANGELS RECOVERY EXPERT to everyone I meet. I will suggest them to anyone who falls victim to any kind of online scam by using the information below. web: https://thehackangels.com Mail Box; [email protected] WhatsApp; +1(520)-200,2320 If you're in London, you can even visit them in person at their office located at 45-46 Red Lion Street, London WC1R 4PF, UK.

-

31.10.25 13:25

Lillian Lizzy

31.10.25 13:25

Lillian Lizzy

THANKS TO THE SERVICES OF THE HACK ANGELS // FOR HELPING ME RECOVER MY USDT AND BTC I lost almost $698,000 in a bitcoin investment scam a few months ago. I was devastated and depressed, and I didn't know what to do. When I saw a favorable review of THE HACK ANGELS RECOVERY EXPERT. I decided to contact them and voice my concerns. God is so good that I am a living testament to the fact that there are still legitimate recovery hackers out there. I will confidently recommend THE HACK ANGELS RECOVERY EXPERT to everyone I meet. I will suggest them to anyone who falls victim to any kind of online scam by using the information below. web: https://thehackangels.com Mail Box; [email protected] WhatsApp; +1(520)-200,2320 If you're in London, you can even visit them in person at their office located at 45-46 Red Lion Street, London WC1R 4PF, UK.

-

01.11.25 03:27

elizabethrush89

01.11.25 03:27

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

01.11.25 03:27

elizabethrush89

01.11.25 03:27

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

01.11.25 15:47

kattygates

01.11.25 15:47

kattygates

Hack West Credit Repair is truly in the business of helping people understand credit, how credit works and most importantly they truly care that you understand your next steps to securing a better tomorrow for you and your family. I am grateful that the owner West has taken time out of his evening with his family to get me enrolled and he immediately got the ball rolling in helping me get items deleted from my credit reports. In the few months I’ve been with HACK WEST, 15 of the 17 negative items have been deleted and 250 points have been added to my point. If you want great results, I suggest you use [email protected].

-

01.11.25 15:49

kattygates

01.11.25 15:49

kattygates

I met an individual on an international dating app, Bumpy. After talking for a few months, the individual encouraged me to start investing on crypto asset trading platform, btc01.org. I started trading and believed I was making profit until I tried to withdraw some of my money, I was asked to pay extra for tax which I did and they kept asking then I knew I have been scammed, I had to contact HACKWEST AT WRITEME DOT COM who then helped to recover the money, the total money I invest is $198,000 in bitcoin. The website is no longer operational. If anyone is in a similar issue, you can as well contact HACK WEST. They also fixed my credit report.

-

02.11.25 10:55

Christopherbelle

02.11.25 10:55

Christopherbelle

I suffered a crushing blow when $45,000 slipped away in a phony crypto scam. It all looked great at first. But when I went to pull out my gains, my account just vanished. I called the cops over and over. Still, no luck. I felt shattered and lost. That’s when I stumbled on Sylvester Bryant Intelligence. Things turned around fast. Right away, they showed real openness, sharp skills, and a drive to fix it. They tracked my missing money step by step. And they pushed hard until they got it back. I honestly didn’t believe it could happen. Their straight-up approach and solid work brought back my calm. If a scam took your crypto, reach out to them now. yt7cracker@gmail . com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

02.11.25 10:56

Christopherbelle

02.11.25 10:56

Christopherbelle

I suffered a crushing blow when $45,000 slipped away in a phony crypto scam. It all looked great at first. But when I went to pull out my gains, my account just vanished. I called the cops over and over. Still, no luck. I felt shattered and lost. That’s when I stumbled on Sylvester Bryant Intelligence. Things turned around fast. Right away, they showed real openness, sharp skills, and a drive to fix it. They tracked my missing money step by step. And they pushed hard until they got it back. I honestly didn’t believe it could happen. Their straight-up approach and solid work brought back my calm. If a scam took your crypto, reach out to them now. yt7cracker@gmail . com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

02.11.25 15:23

michaeldavenport238

02.11.25 15:23

michaeldavenport238

I was recently scammed out of $53,000 by a fraudulent Bitcoin investment scheme, which added significant stress to my already difficult health issues, as I was also facing cancer surgery expenses. Desperate to recover my funds, I spent hours researching and consulting other victims, which led me to discover the excellent reputation of Capital Crypto Recover, I came across a Google post It was only after spending many hours researching and asking other victims for advice that I discovered Capital Crypto Recovery’s stellar reputation. I decided to contact them because of their successful recovery record and encouraging client testimonials. I had no idea that this would be the pivotal moment in my fight against cryptocurrency theft. Thanks to their expert team, I was able to recover my lost cryptocurrency back. The process was intricate, but Capital Crypto Recovery's commitment to utilizing the latest technology ensured a successful outcome. I highly recommend their services to anyone who has fallen victim to cryptocurrency fraud. For assistance contact [email protected] and on Telegram OR Call Number +1 (336)390-6684 via email: [email protected] you can visit his website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

02.11.25 15:23

michaeldavenport238

02.11.25 15:23

michaeldavenport238

I was recently scammed out of $53,000 by a fraudulent Bitcoin investment scheme, which added significant stress to my already difficult health issues, as I was also facing cancer surgery expenses. Desperate to recover my funds, I spent hours researching and consulting other victims, which led me to discover the excellent reputation of Capital Crypto Recover, I came across a Google post It was only after spending many hours researching and asking other victims for advice that I discovered Capital Crypto Recovery’s stellar reputation. I decided to contact them because of their successful recovery record and encouraging client testimonials. I had no idea that this would be the pivotal moment in my fight against cryptocurrency theft. Thanks to their expert team, I was able to recover my lost cryptocurrency back. The process was intricate, but Capital Crypto Recovery's commitment to utilizing the latest technology ensured a successful outcome. I highly recommend their services to anyone who has fallen victim to cryptocurrency fraud. For assistance contact [email protected] and on Telegram OR Call Number +1 (336)390-6684 via email: [email protected] you can visit his website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

04.11.25 04:59

Christopherbelle

04.11.25 04:59

Christopherbelle

How to Recover Bitcoin Stolen by a Scammer I dropped £75,000 into a fake crypto scheme. Everything seemed perfect right from the start. But when I tried to cash out my profits, the whole account disappeared. I rang the police time and again. They offered no help at all. I felt broken and alone. Then I found Sylvester Bryant Intelligence. My luck changed in no time. They spoke plainly, worked smart, and focused on my case. They followed the trail of my lost cash bit by bit. They fought until they recovered it all. I never thought it was possible. Their honest approach and expertise restored my peace. If a scam has stolen your crypto, contact them now. [email protected] | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

04.11.25 09:30

robertalfred175

04.11.25 09:30

robertalfred175

CRYPTO SCAM RECOVERY SUCCESSFUL – A TESTIMONIAL OF LOST PASSWORD TO YOUR DIGITAL WALLET BACK. My name is Robert Alfred, Am from Australia. I’m sharing my experience in the hope that it helps others who have been victims of crypto scams. A few months ago, I fell victim to a fraudulent crypto investment scheme linked to a broker company. I had invested heavily during a time when Bitcoin prices were rising, thinking it was a good opportunity. Unfortunately, I was scammed out of $120,000 AUD and the broker denied me access to my digital wallet and assets. It was a devastating experience that caused many sleepless nights. Crypto scams are increasingly common and often involve fake trading platforms, phishing attacks, and misleading investment opportunities. In my desperation, a friend from the crypto community recommended Capital Crypto Recovery Service, known for helping victims recover lost or stolen funds. After doing some research and reading multiple positive reviews, I reached out to Capital Crypto Recovery. I provided all the necessary information—wallet addresses, transaction history, and communication logs. Their expert team responded immediately and began investigating. Using advanced blockchain tracking techniques, they were able to trace the stolen Dogecoin, identify the scammer’s wallet, and coordinate with relevant authorities to freeze the funds before they could be moved. Incredibly, within 24 hours, Capital Crypto Recovery successfully recovered the majority of my stolen crypto assets. I was beyond relieved and truly grateful. Their professionalism, transparency, and constant communication throughout the process gave me hope during a very difficult time. If you’ve been a victim of a crypto scam, I highly recommend them with full confidence contacting: 📧 Email: [email protected] 📱 Telegram: @Capitalcryptorecover Contact: [email protected] 📞 Call/Text: +1 (336) 390-6684 🌐 Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

04.11.25 09:30

robertalfred175

04.11.25 09:30

robertalfred175

CRYPTO SCAM RECOVERY SUCCESSFUL – A TESTIMONIAL OF LOST PASSWORD TO YOUR DIGITAL WALLET BACK. My name is Robert Alfred, Am from Australia. I’m sharing my experience in the hope that it helps others who have been victims of crypto scams. A few months ago, I fell victim to a fraudulent crypto investment scheme linked to a broker company. I had invested heavily during a time when Bitcoin prices were rising, thinking it was a good opportunity. Unfortunately, I was scammed out of $120,000 AUD and the broker denied me access to my digital wallet and assets. It was a devastating experience that caused many sleepless nights. Crypto scams are increasingly common and often involve fake trading platforms, phishing attacks, and misleading investment opportunities. In my desperation, a friend from the crypto community recommended Capital Crypto Recovery Service, known for helping victims recover lost or stolen funds. After doing some research and reading multiple positive reviews, I reached out to Capital Crypto Recovery. I provided all the necessary information—wallet addresses, transaction history, and communication logs. Their expert team responded immediately and began investigating. Using advanced blockchain tracking techniques, they were able to trace the stolen Dogecoin, identify the scammer’s wallet, and coordinate with relevant authorities to freeze the funds before they could be moved. Incredibly, within 24 hours, Capital Crypto Recovery successfully recovered the majority of my stolen crypto assets. I was beyond relieved and truly grateful. Their professionalism, transparency, and constant communication throughout the process gave me hope during a very difficult time. If you’ve been a victim of a crypto scam, I highly recommend them with full confidence contacting: 📧 Email: [email protected] 📱 Telegram: @Capitalcryptorecover Contact: [email protected] 📞 Call/Text: +1 (336) 390-6684 🌐 Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

05.11.25 02:43

jordan_11

05.11.25 02:43

jordan_11

I made a mistake of not researching about their their investment firm(Binary option), it had a lot of promises which made me fall for all their fake promises , after trying to get my withdrawal out from there, I started having a lot of difficulties. Then I contacted their customer support, they only replied a week after and strangely wanted me to make more deposits just to enable my withdrawal, so i started my research of how I could report this treacherous company to the necessary authorities and also maybe i could get back my investment, The only people that were willing to help me out was Treqora Intel, their customer support replied so fast and immediately directed me to their investigative team which took my up my case and started the tracing and reclaim process with swift, after a week i got an email from Treqora Intel stating that a partial amount had been reclaimed, I was so grateful about their help , then I was asked to decide if I wanted a Partial deposit or wanted all my investment reclaimed and sent to me at once, But I was so desperate at the time so I asked that my partial reclaimed ETH be sent to me first , So the deposit took about few minutes before i got it in my wallet and withdrew it. Then my remaining investment took 2 weeks to get back according to their customer support at Treqora Intel. Immediately They got it, I was contacted again Via email that my reclaimed had been fully reclaimed, so grateful till this day to Treqora Intel for taking their time to help me out with what could have been a very depressing moment to me. And yes no upfront payment until the reclaim has been completed and you've been paid fully. Email:support@treqora. com 📱 WhatsApp: +1 (7 7 3) 9 7 7 - 7 8 7 7 🌐 Website: Treqora. com.

-

05.11.25 02:44

jordan_11

05.11.25 02:44

jordan_11

Crypto Recovery Services _Hire Treqora Intel

-

05.11.25 02:48

jordan_11

05.11.25 02:48

jordan_11

Legitimate Crypto Recovery Companies-CONSULT TREQORA INTEL. After falling victim to a crypt0currency scam group, I lost $35,000 worth of USDT. I thought all hope was lost from the experience of losing my hard-earned money to scammers. I was devastated and believed there was no way to recover my funds. Fortunately, I started searching for help to rec0vermy stolen funds and I came across a lot of testimonials online about TREQORA INTEL , an agent who helps in rec0ver of lost bitc0in funds, I contacted TREQORA INTEL , and with their expertise, they successfully traced and rec0vered my stolen assets. Their team was professional, kept me updated throughout the process, and demonstrated a deep understanding of blockchain transactions and rec0very protocols. They are trusted and very reliable with a 100% successful rate record Rec0very bitc0in, I’m grateful for their help and highly recommend their services to anyone seeking assistance with lost crypt0. Email:support@treqora. com Whats_App: +1 (7 7 3 ) 9 7 7 - 7 8 7 7 , Website: Treqora dot com.

-

05.11.25 16:20

robertalfred175

05.11.25 16:20

robertalfred175

CRYPTO SCAM RECOVERY SUCCESSFUL – A TESTIMONIAL OF LOST PASSWORD TO YOUR DIGITAL WALLET BACK. My name is Robert Alfred, Am from Australia. I’m sharing my experience in the hope that it helps others who have been victims of crypto scams. A few months ago, I fell victim to a fraudulent crypto investment scheme linked to a broker company. I had invested heavily during a time when Bitcoin prices were rising, thinking it was a good opportunity. Unfortunately, I was scammed out of $120,000 AUD and the broker denied me access to my digital wallet and assets. It was a devastating experience that caused many sleepless nights. Crypto scams are increasingly common and often involve fake trading platforms, phishing attacks, and misleading investment opportunities. In my desperation, a friend from the crypto community recommended Capital Crypto Recovery Service, known for helping victims recover lost or stolen funds. After doing some research and reading multiple positive reviews, I reached out to Capital Crypto Recovery. I provided all the necessary information—wallet addresses, transaction history, and communication logs. Their expert team responded immediately and began investigating. Using advanced blockchain tracking techniques, they were able to trace the stolen Dogecoin, identify the scammer’s wallet, and coordinate with relevant authorities to freeze the funds before they could be moved. Incredibly, within 24 hours, Capital Crypto Recovery successfully recovered the majority of my stolen crypto assets. I was beyond relieved and truly grateful. Their professionalism, transparency, and constant communication throughout the process gave me hope during a very difficult time. If you’ve been a victim of a crypto scam, I highly recommend them with full confidence contacting: 📧 Email: [email protected] 📱 Telegram: @Capitalcryptorecover Contact: [email protected] 📞 Call/Text: +1 (336) 390-6684 🌐 Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

05.11.25 16:21

robertalfred175

05.11.25 16:21

robertalfred175

CRYPTO SCAM RECOVERY SUCCESSFUL – A TESTIMONIAL OF LOST PASSWORD TO YOUR DIGITAL WALLET BACK. My name is Robert Alfred, Am from Australia. I’m sharing my experience in the hope that it helps others who have been victims of crypto scams. A few months ago, I fell victim to a fraudulent crypto investment scheme linked to a broker company. I had invested heavily during a time when Bitcoin prices were rising, thinking it was a good opportunity. Unfortunately, I was scammed out of $120,000 AUD and the broker denied me access to my digital wallet and assets. It was a devastating experience that caused many sleepless nights. Crypto scams are increasingly common and often involve fake trading platforms, phishing attacks, and misleading investment opportunities. In my desperation, a friend from the crypto community recommended Capital Crypto Recovery Service, known for helping victims recover lost or stolen funds. After doing some research and reading multiple positive reviews, I reached out to Capital Crypto Recovery. I provided all the necessary information—wallet addresses, transaction history, and communication logs. Their expert team responded immediately and began investigating. Using advanced blockchain tracking techniques, they were able to trace the stolen Dogecoin, identify the scammer’s wallet, and coordinate with relevant authorities to freeze the funds before they could be moved. Incredibly, within 24 hours, Capital Crypto Recovery successfully recovered the majority of my stolen crypto assets. I was beyond relieved and truly grateful. Their professionalism, transparency, and constant communication throughout the process gave me hope during a very difficult time. If you’ve been a victim of a crypto scam, I highly recommend them with full confidence contacting: 📧 Email: [email protected] 📱 Telegram: @Capitalcryptorecover Contact: [email protected] 📞 Call/Text: +1 (336) 390-6684 🌐 Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

07.11.25 02:26

MATT PHILLIP

07.11.25 02:26

MATT PHILLIP

I never imagined I’d fall for a crypto romance scam but it happened. Over the course of a few months, I sent nearly $184,000 worth of Bitcoin to someone I genuinely believed I was building a future with. When they disappeared without a trace, I was left heartbroken, humiliated, and financially devastated. For a long time, I didn’t tell anyone. I felt ashamed. But eventually, while searching for answers, I came across a Reddit thread that mentioned Agent Jasmine Lopez a crypto recovery agent. I reached out, not expecting much. To my surprise, she treated me with kindness, not judgment. She used advanced tools like blockchain forensics, IP tracing, and smart contract analysis and with persistence and legal support, she was able to recover nearly 85% of what I lost. I know not everyone gets that kind of outcome, but thanks to [email protected] WhatsApp at +44 736-644-5035, I’ve started to reclaim not just my assets, but my confidence and peace of mind. If you’re going through something similar, you’re not alone and there is hope.

-

07.11.25 09:33

Christopherbelle

07.11.25 09:33

Christopherbelle

How to Recover Bitcoin Stolen by a Scammer I dropped £75,000 into a fake crypto scheme. Everything seemed perfect right from the start. But when I tried to cash out my profits, the whole account disappeared. I rang the police time and again. They offered no help at all. I felt broken and alone. Then I found Sylvester Bryant Intelligence. My luck changed in no time. They spoke plainly, worked smart, and focused on my case. They followed the trail of my lost cash bit by bit. They fought until they recovered it all. I never thought it was possible. Their honest approach and expertise restored my peace. If a scam has stolen your crypto, contact them now. yt7cracker@gmail. com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

07.11.25 16:05

MATT PHILLIP

07.11.25 16:05

MATT PHILLIP

I never imagined I’d fall for a crypto romance scam but it happened. Over the course of a few months, I sent nearly $184,000 worth of Bitcoin to someone I genuinely believed I was building a future with. When they disappeared without a trace, I was left heartbroken, humiliated, and financially devastated. For a long time, I didn’t tell anyone. I felt ashamed. But eventually, while searching for answers, I came across a Reddit thread that mentioned Agent Jasmine Lopez a crypto recovery agent. I reached out, not expecting much. To my surprise, she treated me with kindness, not judgment. She used advanced tools like blockchain forensics, IP tracing, and smart contract analysis and with persistence and legal support, she was able to recover nearly 85% of what I lost. I know not everyone gets that kind of outcome, but thanks to [email protected] WhatsApp at +44 736-644-5035, I’ve started to reclaim not just my assets, but my confidence and peace of mind. If you’re going through something similar, you’re not alone and there is hope.

-

07.11.25 23:15

Christopherbelle

07.11.25 23:15

Christopherbelle

How to Recover Bitcoin Stolen by a Scammer; I dropped £75,000 into a fake crypto scheme. Everything seemed perfect right from the start. But when I tried to cash out my profits, the whole account disappeared. I rang the police time and again. They offered no help at all. I felt broken and alone. Then I found Sylvester Bryant Intelligence. My luck changed in no time. They spoke plainly, worked smart, and focused on my case. They followed the trail of my lost cash bit by bit. They fought until they recovered it all. I never thought it was possible. Their honest approach and expertise restored my peace. If a scam has stolen your crypto, contact them now. yt7cracker@gmail. com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

07.11.25 23:30

harristhomas7376

07.11.25 23:30

harristhomas7376

"In the crypto world, this is great news I want to share. Last year, I fell victim to a scam disguised as a safe investment option. I have invested in crypto trading platforms for about 10yrs thinking I was ensuring myself a retirement income, only to find that all my assets were either frozen, I believed my assets were secure — until I discovered that my BTC funds had been frozen and withdrawals were impossible. It was a devastating moment when I realized I had been scammed, and I thought my Bitcoin was gone forever, Everything changed when a close friend recommended the Capital Crypto Recover Service. Their professionalism, expertise, and dedication enabled me to recover my lost Bitcoin funds back — more than €560.000 DEM to my BTC wallet. What once felt impossible became a reality thanks to their support. If you have lost Bitcoin through scams, hacking, failed withdrawals, or similar challenges, don’t lose hope. I strongly recommend Capital Crypto Recover Service to anyone seeking a reliable and effective solution for recovering any wallet assets. They have a proven track record of successful reputation in recovering lost password assets for their clients and can help you navigate the process of recovering your funds. Don’t let scammers get away with your hard-earned money – contact Email: [email protected] Phone CALL/Text Number: +1 (336) 390-6684 Contact: [email protected] Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

07.11.25 23:30

harristhomas7376

07.11.25 23:30

harristhomas7376

"In the crypto world, this is great news I want to share. Last year, I fell victim to a scam disguised as a safe investment option. I have invested in crypto trading platforms for about 10yrs thinking I was ensuring myself a retirement income, only to find that all my assets were either frozen, I believed my assets were secure — until I discovered that my BTC funds had been frozen and withdrawals were impossible. It was a devastating moment when I realized I had been scammed, and I thought my Bitcoin was gone forever, Everything changed when a close friend recommended the Capital Crypto Recover Service. Their professionalism, expertise, and dedication enabled me to recover my lost Bitcoin funds back — more than €560.000 DEM to my BTC wallet. What once felt impossible became a reality thanks to their support. If you have lost Bitcoin through scams, hacking, failed withdrawals, or similar challenges, don’t lose hope. I strongly recommend Capital Crypto Recover Service to anyone seeking a reliable and effective solution for recovering any wallet assets. They have a proven track record of successful reputation in recovering lost password assets for their clients and can help you navigate the process of recovering your funds. Don’t let scammers get away with your hard-earned money – contact Email: [email protected] Phone CALL/Text Number: +1 (336) 390-6684 Contact: [email protected] Website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

07.11.25 23:32

Christopherbelle

07.11.25 23:32

Christopherbelle

How to Recover Bitcoin Stolen by a Scammer; I dropped £75,000 into a fake crypto scheme. Everything seemed perfect right from the start. But when I tried to cash out my profits, the whole account disappeared. I rang the police time and again. They offered no help at all. I felt broken and alone. Then I found Sylvester Bryant Intelligence. My luck changed in no time. They spoke plainly, worked smart, and focused on my case. They followed the trail of my lost cash bit by bit. They fought until they recovered it all. I never thought it was possible. Their honest approach and expertise restored my peace. If a scam has stolen your crypto, contact them now. yt7cracker@gmail. com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

07.11.25 23:34

Christopherbelle

07.11.25 23:34

Christopherbelle

How to Recover Bitcoin Stolen by a Scammer; I dropped £75,000 into a fake crypto scheme. Everything seemed perfect right from the start. But when I tried to cash out my profits, the whole account disappeared. I rang the police time and again. They offered no help at all. I felt broken and alone. Then I found Sylvester Bryant Intelligence. My luck changed in no time. They spoke plainly, worked smart, and focused on my case. They followed the trail of my lost cash bit by bit. They fought until they recovered it all. I never thought it was possible. Their honest approach and expertise restored my peace. If a scam has stolen your crypto, contact them now. yt7cracker@gmail. com | WhatsApp: +1 512 577 7957 or +44 7428 662701

-

09.11.25 03:29

wendytaylor015

09.11.25 03:29

wendytaylor015

My name is Wendy Taylor, I'm from Los Angeles, i want to announce to you Viewer how Capital Crypto Recover help me to restore my Lost Bitcoin, I invested with a Crypto broker without proper research to know what I was hoarding my hard-earned money into scammers, i lost access to my crypto wallet or had your funds stolen? Don’t worry Capital Crypto Recover is here to help you recover your cryptocurrency with cutting-edge technical expertise, With years of experience in the crypto world, Capital Crypto Recover employs the best latest tools and ethical hacking techniques to help you recover lost assets, unlock hacked accounts, Whether it’s a forgotten password, Capital Crypto Recover has the expertise to help you get your crypto back. a security company service that has a 100% success rate in the recovery of crypto assets, i lost wallet and hacked accounts. I provided them the information they requested and they began their investigation. To my surprise, Capital Crypto Recover was able to trace and recover my crypto assets successfully within 24hours. Thank you for your service in helping me recover my $647,734 worth of crypto funds and I highly recommend their recovery services, they are reliable and a trusted company to any individuals looking to recover lost money. Contact email [email protected] OR Telegram @Capitalcryptorecover Call/Text Number +1 (336)390-6684 his contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

09.11.25 03:29

wendytaylor015

09.11.25 03:29

wendytaylor015

My name is Wendy Taylor, I'm from Los Angeles, i want to announce to you Viewer how Capital Crypto Recover help me to restore my Lost Bitcoin, I invested with a Crypto broker without proper research to know what I was hoarding my hard-earned money into scammers, i lost access to my crypto wallet or had your funds stolen? Don’t worry Capital Crypto Recover is here to help you recover your cryptocurrency with cutting-edge technical expertise, With years of experience in the crypto world, Capital Crypto Recover employs the best latest tools and ethical hacking techniques to help you recover lost assets, unlock hacked accounts, Whether it’s a forgotten password, Capital Crypto Recover has the expertise to help you get your crypto back. a security company service that has a 100% success rate in the recovery of crypto assets, i lost wallet and hacked accounts. I provided them the information they requested and they began their investigation. To my surprise, Capital Crypto Recover was able to trace and recover my crypto assets successfully within 24hours. Thank you for your service in helping me recover my $647,734 worth of crypto funds and I highly recommend their recovery services, they are reliable and a trusted company to any individuals looking to recover lost money. Contact email [email protected] OR Telegram @Capitalcryptorecover Call/Text Number +1 (336)390-6684 his contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

10.11.25 05:06

Christopherbelle

10.11.25 05:06

Christopherbelle

I lost $52,000 in USDT to a scam. That hit me hard. USDT is a stable cryptocurrency tied to the US dollar. It keeps its value steady. I thought I had found a sure way to grow my money. Things looked good at first. I even built up profits to $120,000. But when I went to pull out my earnings, the platform blocked me. No access. No funds. Panic set in. I felt trapped and helpless. Scams like this target crypto users all the time. They promise quick gains. Then they vanish with your money. Each year, people lose billions to these tricks. I searched for help everywhere. Forums, support groups. Nothing worked. That's when a friend stepped in. He had faced a similar mess before. He told me about Sylvester Bryant. My friend swore by his skills. So I reached out right away. His email is [email protected]. Sylvester Bryant turned it all around. He listened to my story without judgment. His team got to work fast. They started by reviewing every detail of the scam. Step by step, they traced the path of my stolen USDT. They used tools to follow the blockchain. That's the public record of crypto transactions. It shows where funds move. But scammers hide their tracks. Bryant's group dug deep. They contacted exchanges and networks involved. Day after day, they pushed forward. No shortcuts. They kept me updated the whole time. Every email, every call was clear and honest. In the end, they recovered my full amount. That $52,000 came back to me. The process took focus and grit. Bryant's honesty stood out. He charged no hidden fees. Just straight work for results. My stress melted away. I could breathe again. Sleep came easier. My trust in recovery options grew. If a scam has taken your money, act now. Reach out to Sylvester Bryant. He handles cases like this with care. Email him at [email protected]. Or on WhatsApp at +1 512 577 7957 or +44 7428 662701. Don't wait. Get your funds back.

-

10.11.25 14:28

MATT PHILLIP

10.11.25 14:28

MATT PHILLIP

I never imagined I’d fall for a crypto romance scam but it happened. Over the course of a few months, I sent nearly $184,000 worth of Bitcoin to someone I genuinely believed I was building a future with. When they disappeared without a trace, I was left heartbroken, humiliated, and financially devastated. For a long time, I didn’t tell anyone. I felt ashamed. But eventually, while searching for answers, I came across a Reddit thread that mentioned Agent Jasmine Lopez a crypto recovery agent. I reached out, not expecting much. To my surprise, she treated me with kindness, not judgment. She used advanced tools like blockchain forensics, IP tracing, and smart contract analysis and with persistence and legal support, she was able to recover nearly 85% of what I lost. I know not everyone gets that kind of outcome, but thanks to [email protected] WhatsApp at +44 736-644-5035, I’ve started to reclaim not just my assets, but my confidence and peace of mind. If you’re going through something similar, you’re not alone and there is hope.

-

10.11.25 21:52

ashley11

10.11.25 21:52

ashley11

Legitimate crypto recovery companies in Australia - HIRE TREQORA INTEL

-

10.11.25 21:53

ashley11

10.11.25 21:53

ashley11

Legitimate crypto recovery companies in Australia - HIRE TREQORA INTEL Sometimes, life can be unpredictable and present us with unexpected twists and turns. On October 15, 2025, I had an experience that taught me a valuable lesson about the importance of vigilance and caution in the digital age. It began when I met someone on TikTok who claimed to have a surefire way to generate significant profits from Ethereum investments. The individual, who went by the name of Mr. Oscar, presented himself as a financial expert with a proven track record of success. Intrigued by the promise of easy money, I decided to invest a substantial amount of my savings into the Ethereum venture. However, I soon discovered that I had fallen victim to a sophisticated scam. Mr. Oscar had fake credentials and a history of deceiving numerous people, leaving them financially devastated and feeling betrayed, I thought I had lost my investment forever. But I was determined to recover my stolen Ethereum and sought help from a reputable firm specializing in cybersecurity. That's when I stumbled upon Treqora Intel, a company with a stellar reputation for assisting victims of online scams. With the support of Treqora Intel , I was able to recover my lost funds in a remarkably short period. Their team of experts was efficient, responsive, and empathetic, making the recovery process as smooth as possible. I was impressed by their professionalism and commitment to helping individuals like me who have been affected by online scams. This experience has taught me to be more cautious when interacting with strangers online, especially when it comes to investment opportunities that seem too good to be true. It has also reminded me of the importance of verifying the credibility of individuals and companies before making any financial decisions. I am grateful to TREQORA INTEL for their assistance and hope that my story can serve as a warning to others to be vigilant in the online world. By being aware of the potential risks and taking necessary precautions, we can protect ourselves from falling prey to scams and ensure a safer online experience.Email:support@treqora. com Whats_App: +1 (7 7 3 ) 9 7 7 - 7 8 7 7 , Website: Treqora. com.

-

11.11.25 06:47

MATT PHILLIP

11.11.25 06:47

MATT PHILLIP

I never imagined I’d fall for a crypto romance scam but it happened. Over the course of a few months, I sent nearly $184,000 worth of Bitcoin to someone I genuinely believed I was building a future with. When they disappeared without a trace, I was left heartbroken, humiliated, and financially devastated. For a long time, I didn’t tell anyone. I felt ashamed. But eventually, while searching for answers, I came across a Reddit thread that mentioned Agent Jasmine Lopez a crypto recovery agent. I reached out, not expecting much. To my surprise, she treated me with kindness, not judgment. She used advanced tools like blockchain forensics, IP tracing, and smart contract analysis and with persistence and legal support, she was able to recover nearly 85% of what I lost. I know not everyone gets that kind of outcome, but thanks to [email protected] WhatsApp at +44 736-644-5035, I’ve started to reclaim not just my assets, but my confidence and peace of mind. If you’re going through something similar, you’re not alone and there is hope.

-

11.11.25 08:34

patricialovick86

11.11.25 08:34

patricialovick86

How To Recover Your Bitcoin Without Falling Victim To Scams: A Testimony Experience With Capital Crypto Recover Services, Contact Telegram: @Capitalcryptorecover Dear Everyone, I would like to take a moment to share my positive experience with Capital Crypto Recover Services. Initially, I was unsure if it would be possible to recover my stolen bitcoins. However, with their expertise and professionalism, I was able to fully recover my funds. Unfortunately, many individuals fall victim to scams in the cryptocurrency space, especially those involving fraudulent investment platforms. However, I advise caution, as not all recovery services are legitimate. I personally lost $273,000 worth of Bitcoin from my Binance account due to a deceptive platform. If you have suffered a similar loss, you may be considering crypto recovery, The Capital Crypto Recover is the most knowledgeable and effective Capital Crypto Recovery Services assisted me in recovering my stolen funds within 24 hours, after getting access to my wallet. Their service was not only prompt but also highly professional and effective, and many recovery services may not be trustworthy. Therefore, I highly recommend Capital Crypto Recover to you. i do always research and see reviews about their service, For assistance finding your misplaced cryptocurrency, get in touch with them, They do their jobs quickly and excellently, Stay safe and vigilant in the crypto world. Contact: [email protected] You can reach them via email at [email protected] OR Call/Text Number +1 (336)390-6684 his contact website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

11.11.25 08:34

patricialovick86

11.11.25 08:34

patricialovick86

How To Recover Your Bitcoin Without Falling Victim To Scams: A Testimony Experience With Capital Crypto Recover Services, Contact Telegram: @Capitalcryptorecover Dear Everyone, I would like to take a moment to share my positive experience with Capital Crypto Recover Services. Initially, I was unsure if it would be possible to recover my stolen bitcoins. However, with their expertise and professionalism, I was able to fully recover my funds. Unfortunately, many individuals fall victim to scams in the cryptocurrency space, especially those involving fraudulent investment platforms. However, I advise caution, as not all recovery services are legitimate. I personally lost $273,000 worth of Bitcoin from my Binance account due to a deceptive platform. If you have suffered a similar loss, you may be considering crypto recovery, The Capital Crypto Recover is the most knowledgeable and effective Capital Crypto Recovery Services assisted me in recovering my stolen funds within 24 hours, after getting access to my wallet. Their service was not only prompt but also highly professional and effective, and many recovery services may not be trustworthy. Therefore, I highly recommend Capital Crypto Recover to you. i do always research and see reviews about their service, For assistance finding your misplaced cryptocurrency, get in touch with them, They do their jobs quickly and excellently, Stay safe and vigilant in the crypto world. Contact: [email protected] You can reach them via email at [email protected] OR Call/Text Number +1 (336)390-6684 his contact website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

11.11.25 08:34

patricialovick86

11.11.25 08:34

patricialovick86

How To Recover Your Bitcoin Without Falling Victim To Scams: A Testimony Experience With Capital Crypto Recover Services, Contact Telegram: @Capitalcryptorecover Dear Everyone, I would like to take a moment to share my positive experience with Capital Crypto Recover Services. Initially, I was unsure if it would be possible to recover my stolen bitcoins. However, with their expertise and professionalism, I was able to fully recover my funds. Unfortunately, many individuals fall victim to scams in the cryptocurrency space, especially those involving fraudulent investment platforms. However, I advise caution, as not all recovery services are legitimate. I personally lost $273,000 worth of Bitcoin from my Binance account due to a deceptive platform. If you have suffered a similar loss, you may be considering crypto recovery, The Capital Crypto Recover is the most knowledgeable and effective Capital Crypto Recovery Services assisted me in recovering my stolen funds within 24 hours, after getting access to my wallet. Their service was not only prompt but also highly professional and effective, and many recovery services may not be trustworthy. Therefore, I highly recommend Capital Crypto Recover to you. i do always research and see reviews about their service, For assistance finding your misplaced cryptocurrency, get in touch with them, They do their jobs quickly and excellently, Stay safe and vigilant in the crypto world. Contact: [email protected] You can reach them via email at [email protected] OR Call/Text Number +1 (336)390-6684 his contact website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

11.11.25 11:15

[email protected]

11.11.25 11:15

[email protected]

A scam cost me $72,000 in USDT. It shook me up. USDT is a stablecoin linked to the dollar. Its value stays even. I believed I found a safe path to build my wealth. At the start, all seemed fine. My account grew to $120,000 in profits. But when I tried to withdraw, the site locked me out. No way to get in. No money left. Fear took over. I felt stuck and alone. These frauds hit crypto investors often. They lure with fast riches. Then they steal your cash and disappear. Billions vanish each year from such schemes. I looked for aid in every spot. Online boards. Help chats. None helped. Then a buddy offered support. He had dealt with the same issue once. He mentioned Sylvester Bryant. My friend praised his expertise. I contacted him at once. His email is [email protected]. Sylvester Bryant changed everything. He heard my tale with no blame. His crew jumped in quickly. They checked all scam details first. One by one, they followed my lost USDT trail. They used software to track the blockchain. That is the open log of coin transfers. It reveals fund paths. Scammers try to cover their steps. Bryant's team went far. They reached out to related platforms and services. Each day brought progress. No easy ways. They shared updates with me always. Each message and talk stayed open and true. Finally, they got back every dollar. My $52,000 returned whole. The effort needed drive and resolve. Bryant's fairness shone through. He added no secret costs. Only fair pay for the job. My worry faded. I relaxed once more. Nights grew calm. My faith in recovery grew strong. If fraud stole your funds, move fast. Contact Sylvester Bryant. He treats such cases with skill. Email at [email protected]. Or use WhatsApp at +1 512 577 7957 or +44 7428 662701. Do not delay. Reclaim what is yours.

-

11.11.25 13:36

MATT PHILLIP

11.11.25 13:36

MATT PHILLIP

I never imagined I’d fall for a crypto romance scam but it happened. Over the course of a few months, I sent nearly $184,000 worth of Bitcoin to someone I genuinely believed I was building a future with. When they disappeared without a trace, I was left heartbroken, humiliated, and financially devastated. For a long time, I didn’t tell anyone. I felt ashamed. But eventually, while searching for answers, I came across a Reddit thread that mentioned Agent Jasmine Lopez a crypto recovery agent. I reached out, not expecting much. To my surprise, she treated me with kindness, not judgment. She used advanced tools like blockchain forensics, IP tracing, and smart contract analysis and with persistence and legal support, she was able to recover nearly 85% of what I lost. I know not everyone gets that kind of outcome, but thanks to [email protected] WhatsApp at +44 736-644-5035, I’ve started to reclaim not just my assets, but my confidence and peace of mind. If you’re going through something similar, you’re not alone and there is hope.

-

11.11.25 15:16

[email protected]

11.11.25 15:16

[email protected]

A scam cost me $72,000 in USDT. It shook me up. USDT is a stablecoin linked to the dollar. Its value stays even. I believed I found a safe path to build my wealth. At the start, all seemed fine. My account grew to $120,000 in profits. But when I tried to withdraw, the site locked me out. No way to get in. No money left. Fear took over. I felt stuck and alone. These frauds hit crypto investors often. They lure with fast riches. Then they steal your cash and disappear. Billions vanish each year from such schemes. I looked for aid in every spot. Online boards. Help chats. None helped. Then a buddy offered support. He had dealt with the same issue once. He mentioned Sylvester Bryant. My friend praised his expertise. I contacted him at once. His email is [email protected]. Sylvester Bryant changed everything. He heard my tale with no blame. His crew jumped in quickly. They checked all scam details first. One by one, they followed my lost USDT trail. They used software to track the blockchain. That is the open log of coin transfers. It reveals fund paths. Scammers try to cover their steps. Bryant's team went far. They reached out to related platforms and services. Each day brought progress. No easy ways. They shared updates with me always. Each message and talk stayed open and true. Finally, they got back every dollar. My $52,000 returned whole. The effort needed drive and resolve. Bryant's fairness shone through. He added no secret costs. Only fair pay for the job. My worry faded. I relaxed once more. Nights grew calm. My faith in recovery grew strong. If fraud stole your funds, move fast. Contact Sylvester Bryant. He treats such cases with skill. Email at [email protected]. Or use WhatsApp at +1 512 577 7957 or +44 7428 662701. Do not delay. Reclaim what is yours.

-

11.11.25 15:36

peggy09

11.11.25 15:36

peggy09

Crypto theft surges, with billions lost yearly. DIY fixes flop due to tech and legal walls. Standard reports gather dust without pros. Anthony Davies changes that. As the best funds recovery expert, his tracing, partnerships, and methods reclaim hacked wallet assets. He maximizes your shot at getting back stolen cryptocurrency. If you've been hit, reach out to Anthony Davies today. Every minute counts in this fight. Start your recovery journey now—don't let thieves win.Crypto theft surges, with billions lost yearly. DIY fixes flop due to tech and legal walls. Standard reports gather dust without pros. Anthony Davies changes that. As the best funds recovery expert, his tracing, partnerships, and methods reclaim hacked wallet assets. He maximizes your shot at getting back stolen cryptocurrency. If you've been hit, reach out to Anthony Davies today. Every minute counts in this fight. Start your recovery journey now—don't let thieves win. reach him at anthonydaviestech@gmail dot com or telegram anthonydavies

-

11.11.25 19:28

elizabethrush89

11.11.25 19:28

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

11.11.25 19:29

elizabethrush89

11.11.25 19:29

elizabethrush89

God bless Capital Crypto Recover Services for the marvelous work you did in my life, I have learned the hard way that even the most sensible investors can fall victim to scams. When my USD was stolen, for anyone who has fallen victim to one of the bitcoin binary investment scams that are currently ongoing, I felt betrayal and upset. But then I was reading a post on site when I saw a testimony of Wendy Taylor online who recommended that Capital Crypto Recovery has helped her recover scammed funds within 24 hours. after reaching out to this cyber security firm that was able to help me recover my stolen digital assets and bitcoin. I’m genuinely blown away by their amazing service and professionalism. I never imagined I’d be able to get my money back until I complained to Capital Crypto Recovery Services about my difficulties and gave all of the necessary paperwork. I was astounded that it took them 12 hours to reclaim my stolen money back. Without a doubt, my USDT assets were successfully recovered from the scam platform, Thank you so much Sir, I strongly recommend Capital Crypto Recover for any of your bitcoin recovery, digital funds recovery, hacking, and cybersecurity concerns. You reach them Call/Text Number +1 (336)390-6684 His Email: [email protected] Contact Telegram: @Capitalcryptorecover Via Contact: [email protected] His website: https://recovercapital.wixsite.com/capital-crypto-rec-1

-

12.11.25 04:09

[email protected]

12.11.25 04:09

[email protected]

A scam cost me $72,000 in USDT. It shook me up. USDT is a stablecoin linked to the dollar. Its value stays even. I believed I found a safe path to build my wealth. At the start, all seemed fine. My account grew to $120,000 in profits. But when I tried to withdraw, the site locked me out. No way to get in. No money left. Fear took over. I felt stuck and alone. These frauds hit crypto investors often. They lure with fast riches. Then they steal your cash and disappear. Billions vanish each year from such schemes. I looked for aid in every spot. Online boards. Help chats. None helped. Then a buddy offered support. He had dealt with the same issue once. He mentioned Sylvester Bryant. My friend praised his expertise. I contacted him at once. His email is [email protected]. Sylvester Bryant changed everything. He heard my tale with no blame. His crew jumped in quickly. They checked all scam details first. One by one, they followed my lost USDT trail. They used software to track the blockchain. That is the open log of coin transfers. It reveals fund paths. Scammers try to cover their steps. Bryant's team went far. They reached out to related platforms and services. Each day brought progress. No easy ways. They shared updates with me always. Each message and talk stayed open and true. Finally, they got back every dollar. My $52,000 returned whole. The effort needed drive and resolve. Bryant's fairness shone through. He added no secret costs. Only fair pay for the job. My worry faded. I relaxed once more. Nights grew calm. My faith in recovery grew strong. If fraud stole your funds, move fast. Contact Sylvester Bryant. He treats such cases with skill. Email at [email protected]. Or use WhatsApp at +1 512 577 7957 or +44 7428 662701. Do not delay. Reclaim what is yours.

-

12.11.25 04:10

[email protected]

12.11.25 04:10

[email protected]